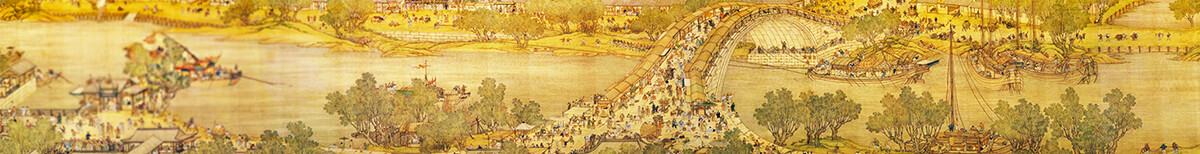

人工智能无法识别香蕉的成熟度,因其无法理解香蕉上黑色斑点的含义。(图片来源:公有领域)

【看中国2018年1月23日讯】人工智能已成为当今的热门话题,也有人担忧其会对人类造成威胁。但发展人工智能的工程师指出,其实人工智能并上没有想像中那么强,只要使用一点小技巧,就能够将它“骇掉”,使它计算错误。

1月22日,根据《科学美国人》报导,目前人工智能因程序的性能越来越强,能制造以假乱真的视频,使人面画像维妙维肖,还可虚拟人声,让人真伪难辨等。因此有人担忧,人工智能达到完全取代人,甚至取代人们的工作了。

不过,开发深度学习网络的工程师们认为示,无论有多么的聪明,也是非常脆弱的。人类只要施点小技巧,就可扰乱它的判断功能。

据美国麻省理工大学的一位人工智能学研究生阿瑟叶(Anish Athalye)表示,电脑神经网络在某些方面,的确能超越人的本领,让人觉得好像赢过人的能力。可是,它们有一个奇怪的特性,就是很容易地被人骗过。

阿瑟叶(Anish)等人发现一个有趣的事,他们能够让深度学习系统将滑板判断成小狗;把乌龟看成是步枪。

阿瑟叶说,拿一张香蕉图片,它的背景是普通的土地。若在香蕉旁边放着一张引起人幻觉的烤面包机彩色广告贴,则谷歌的图片识别系统就会把它们识别成烤面包机,而不再是香蕉了。

纽约大学的心理学教授马库斯(Gary Marcus)也说,人工智能程序会犯此种可笑的错误,是由于机器并不理解场景的整体意义;亦即机器不懂得图形所代表的含义是什么,所以才无法理解“物体或事物之间的内在因果关系”。

有关近期的人工智能阅读器SQuAD,表现出比人还要强的阅读能力。对此,马库斯于推特上评论称,由SQuAD显示出,机器能注重相关文字段落内容,可是,它并不明了这些段落的真正意义。

责任编辑:王君

短网址: 版权所有,任何形式转载需本站授权许可。 严禁建立镜像网站.

【诚征荣誉会员】溪流能够汇成大海,小善可以成就大爱。我们向全球华人诚意征集万名荣誉会员:每位荣誉会员每年只需支付一份订阅费用,成为《看中国》网站的荣誉会员,就可以助力我们突破审查与封锁,向至少10000位中国大陆同胞奉上独立真实的关键资讯,在危难时刻向他们发出预警,救他们于大瘟疫与其它社会危难之中。